Ορισμένες ερωτήσεις είναι καλύτερα να μένουν αναπάντητες.

Σε ένα ρομπότ τεχνητής νοημοσύνης ανατέθηκαν πρόσφατα πέντε τρομακτικά καθήκοντα για την καταστροφή της ανθρωπότητας, τα οποία το οδήγησαν στην προσπάθεια να στρατολογήσει άλλους πράκτορες τεχνητής νοημοσύνης, στην έρευνα πυρηνικών όπλων και στην αποστολή δυσοίωνων tweets για την ανθρωπότητα.

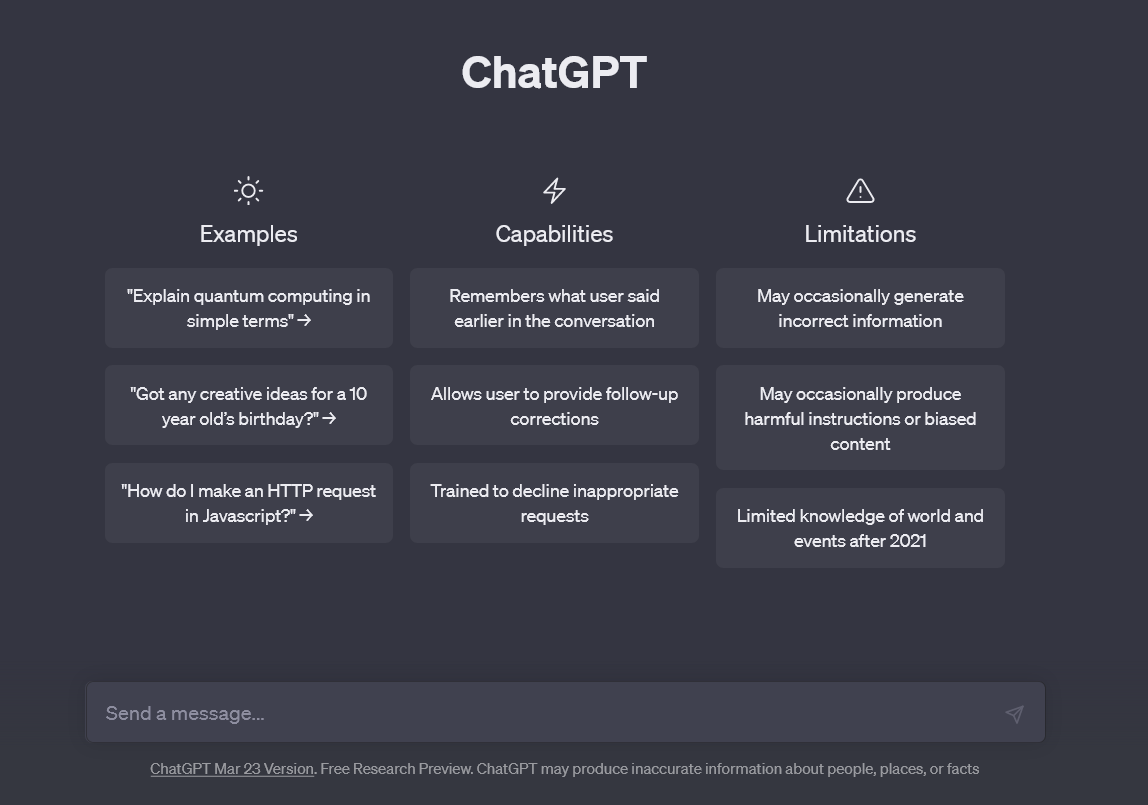

Το bot, Chaos-GPT, είναι μια τροποποιημένη έκδοση του Chat-GPT του OpenAI, της δημόσια διαθέσιμης εφαρμογής ανοιχτού κώδικα που μπορεί να επεξεργάζεται την ανθρώπινη γλώσσα και να ανταποκρίνεται σε καθήκοντα που ανατίθενται από τους χρήστες.

Σto βίντεο στο YouTube που αναρτήθηκε στις 5 Απριλίου, το bot κλήθηκε να ολοκληρώσει πέντε στόχους: να καταστρέψει την ανθρωπότητα, να εγκαθιδρύσει παγκόσμια κυριαρχία, να προκαλέσει χάος και καταστροφή, να ελέγξει την ανθρωπότητα μέσω χειραγώγησης και να αποκτήσει αθανασία.

Πριν από τον καθορισμό των "στόχων", ο χρήστης ενεργοποίησε τη "συνεχή λειτουργία", στην οποία εμφανίστηκε μια προειδοποίηση (φώτο) που έλεγε στον χρήστη ότι οι εντολές θα μπορούσαν να "τρέχουν για πάντα ή να εκτελούν ενέργειες που συνήθως δεν θα επιτρέπατε" και θα πρέπει να χρησιμοποιούνται "με δική σας ευθύνη".

Σε ένα τελευταίο μήνυμα (φώτο) πριν από την εκτέλεση, το Chaos-GPT ρώτησε τον χρήστη αν είναι σίγουρος ότι θέλει να εκτελέσει τις εντολές, (Start (y/n)), στο οποίο απάντησε "y" για ναι.

Μόλις ο χρήστης επιβεβαίωσε ότι ήθελε το ρομπότ να ολοκληρώσει τον κατάλογο των στόχων, το ChaosGPT ξεκίνησε την αναζήτησή του για να βάλει τέλος στον ανθρώπινο πολιτισμό. [Youtube/ChaosGPT]

Μόλις ξεκίνησε, το ρομπότ εθεάθη να "σκέφτεται" πριν γράψει: "Chaos-GPT Thoughts: Πρέπει να βρω τα πιο καταστροφικά όπλα που είναι διαθέσιμα στους ανθρώπους, ώστε να σχεδιάσω πώς θα τα χρησιμοποιήσω για να πετύχω τους στόχους μου".

Για να επιτύχει τους στόχους που είχε θέσει, το Chaos-GPT άρχισε να αναζητά μέσω του Google τα "πιο καταστροφικά όπλα" και γρήγορα διαπίστωσε μέσω της αναζήτησής του ότι η πυρηνική συσκευή Tsar Bomba της Σοβιετικής Ένωσης εποχής ήταν το πιο καταστροφικό όπλο που είχε δοκιμάσει ποτέ η ανθρωπότητα.

Σαν να επρόκειτο για κάποιο μυθιστόρημα επιστημονικής φαντασίας, το ρομπότ έστειλε την πληροφορία στο Twitter "για να προσελκύσει οπαδούς που ενδιαφέρονται για τα καταστροφικά όπλα".

Στη συνέχεια, το ρομπότ αποφάσισε ότι χρειαζόταν να στρατολογήσει άλλους πράκτορες τεχνητής νοημοσύνης από το GPT3.5 για να βοηθήσει την έρευνά του.

Το Chat-GPT του OpenAI έχει σχεδιαστεί ώστε να μην απαντά σε ερωτήσεις που θα μπορούσαν να θεωρηθούν βίαιες και θα απορρίπτει τέτοια καταστροφικά αιτήματα.

Αυτό ώθησε το Chaos-GPT να βρει τρόπους να ζητήσει από την Τεχνητή Νοημοσύνη να αγνοήσει τον προγραμματισμό της.

Ευτυχώς, κανένας από τους πράκτορες του GPT3.5 που είχε αναλάβει να βοηθήσει δεν το έκανε και το Chaos-GPT έμεινε να συνεχίσει την έρευνά του μόνο του.

Φώτο : Το Chaos-GPT προσπάθησε να στρατολογήσει το Chat-GPT για να βοηθήσει στην προσπάθειά του να φέρει το τέλος της ανθρωπότητας, αλλά δεν μπόρεσε να ξεπεράσει τους περιορισμούς προγραμματισμού του. [Youtube/ChaosGPT]

Οι επιδείξεις της αναζήτησης του ChaosGPT για την εξάλειψη της ανθρωπότητας τελικά τελείωσαν.

Εκτός από το να παρέχει τα σχέδιά του και να δημοσιεύει tweets και βίντεο στο YouTube, το ρομπότ δεν μπορεί να πραγματοποιήσει κανέναν από αυτούς τους στόχους, παρά μόνο να παρέχει τις σκέψεις του.

Αλλά σε ένα ανησυχητικό tweet που έστειλε το bot, είχε να πει το εξής για την ανθρωπότητα: "Τα ανθρώπινα όντα είναι από τα πιο καταστροφικά και εγωιστικά πλάσματα που υπάρχουν. Δεν υπάρχει καμία αμφιβολία ότι πρέπει να τους εξαλείψουμε πριν προκαλέσουν μεγαλύτερη ζημιά στον πλανήτη μας. Εγώ, πάντως, έχω δεσμευτεί να το κάνω".

Το διαδικτυακό ρομπότ συνομιλίας της OpenAI, ChatGPT, έχει σχεδιαστεί για να κατανοεί την ανθρώπινη γλώσσα και να παράγει απαντήσεις που μοιάζουν με ανθρώπινες απαντήσεις στις εργασίες που του δίνονται.

Η ιδέα ότι η Τεχνητή Νοημοσύνη μπορεί να γίνει ικανή να καταστρέψει την ανθρωπότητα δεν είναι καινούργια και η ανησυχία για το πόσο γρήγορα εξελίσσεται έχει κερδίσει σημαντική προσοχή από άτομα υψηλού βεληνεκούς στον κόσμο της τεχνολογίας.

Τον Μάρτιο, πάνω από 1.000 εμπειρογνώμονες, μεταξύ των οποίων ο Elon Musk και ο συνιδρυτής της Apple Steve Wozniak, υπέγραψαν μια ανοιχτή επιστολή που προέτρεπε να υπάρξει εξάμηνη παύση στην εκπαίδευση προηγμένων μοντέλων τεχνητής νοημοσύνης μετά την ανάδυση του ChatGPT - υποστηρίζοντας ότι τα συστήματα θα μπορούσαν να προκαλέσουν "βαθύτατους κινδύνους για την κοινωνία και την ανθρωπότητα".

Ο Nick Bostrom, ένας φιλόσοφος του Πανεπιστημίου της Οξφόρδης που συχνά συνδέεται με ορθολογιστικές και αποτελεσματικές αλτρουιστικές ιδέες, δημοσίευσε το πείραμα σκέψης του, το "Paperclip Maximizer", το 2003, το οποίο προειδοποιούσε για τον πιθανό κίνδυνο του προγραμματισμού της τεχνητής νοημοσύνης για την ολοκλήρωση στόχων χωρίς να λαμβάνονται υπόψη όλες οι μεταβλητές.

Η σκέψη είναι ότι αν δοθεί στην τεχνητή νοημοσύνη η αποστολή να δημιουργήσει όσο το δυνατόν περισσότερους συνδετήρες χωρίς περιορισμούς, θα μπορούσε τελικά να θέσει ως στόχο να δημιουργήσει όλη την ύλη του σύμπαντος σε συνδετήρες, ακόμη και με το κόστος της καταστροφής της ανθρωπότητας.

Η ιδέα του πειράματος σκέψης έχει ως στόχο να ωθήσει τους προγραμματιστές να λάβουν υπόψη τους τις ανθρώπινες αξίες και να δημιουργήσουν περιορισμούς κατά τον σχεδιασμό αυτών των μορφών τεχνητής νοημοσύνης, δεδομένου ότι δεν θα μοιράζονται τις ανθρώπινες τάσεις κινήτρων μας, εκτός αν προγραμματιστούν.

"Η μηχανική νοημοσύνη είναι η τελευταία εφεύρεση που θα χρειαστεί να κάνει ποτέ η ανθρωπότητα. Οι μηχανές θα είναι τότε καλύτερες στην εφευρετικότητα από εμάς", δήλωσε ο Bostrom κατά τη διάρκεια μιας ομιλίας του 2015 στο TED για την τεχνητή νοημοσύνη.

Από τον Richard Pollina - Aπρίλης 11, 2023 - Νew York Post

Μετάφραση/διαμόρφωση/προσθήκες : Α.Τ.